测试环境

iSCSI 存储设备:P42.0GHz CPU ,256MB DRAM, IBM DPSS318350 18G硬盘,Redhat Linux 9.0 操作系统;LINUX 服务器:Pentium 42.66GHz ( FC2PGA) CPU ,256MB DRAM, 80GB UltraATA/ 1007 ,200rpm硬盘,Redhat Linux 9.0 操作系统;WINDOWS服务器端:XEON 3.06GHz CPU ,512M DRAM 内存,Smart Array6i (板载) 存储控制器,QlogIC QLA2300 PCI FC Adapter 光纤适配器,IBM 36。4GB (32P0726) 10Krpm 硬盘,MicroSOFt Windows2003操作系统;FC-RAID:NexStor 4000S ,CPU 600MHZ,512M SDRAM,10 ×ST314680FC 硬盘;普通NAS 存储设备: P42.66GHz CPU ,512MB DDR ,Maxtor 160G硬盘,Redhat Linux 9.0 操作系统。

网络连接:iSCSI 设备和普通NAS 设备都使用100M以太网卡ReaLTEk RTL8139 ;Windows 服务器使用1000M 以太网卡HP NC7782 Gigabit Server Adapter ;Linux服务器使用1000M以太网卡。HPNC7782Gigabit Server Adapter。

功能测试

根据测试流程,功能测试包括三个方面的内容: (2) 平台的统一,即在Windows 下能通过单一目录树方式访问多个存储节点,功能与Linux 下的pvfs 相似; (2) 协议的统一,即通过Windows 的“计算机管理”和Initiator 发起端(iSCSI 客户端) 可以管理FC-RAID 和iSCSI Target 及普通的NAS 设备,并利用“动态磁盘机制”实现多种冗余;设备的统一,即iSCSI Target 通过和initiator 配合,使得该Target 成为NAS 系统中的一个存储设备。

性能测试

测试内容

采用第三方的IOMETER 测试软件进行的测试。IOMETER是INTEL 公司专门开发的用于测试系统I/O 性能的测试程序。 它的测试参数比较全面,能非常全面的反映服务器的I/ O性能。为了说明USN 存储系统的性能,在相同条件下测试以下项目进行对比分析: (1) 对USN 服务器本地硬盘读写性能测试; (2) 100M以太网环境下FC-RAID 盘读写性能测试; (3)100M以太网环境下远程iSCSI 盘读写性能测试; (4) 100M 以太网环境下FC-RAID 盘和远程iSCSI 盘构建的各级RAID 盘的读写性能测试; (5) 1000M以太网环境下远程iSCSI 盘读写性能测试; (6) 100M以太网环境下USN 系统的读写性能测试。

实验结果比较

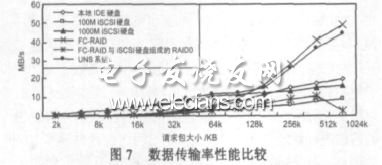

本地IDE 硬盘、100M iSCSI 硬盘、1000M iSCSI 硬盘、FC-RAID、FC-RAID 与iSCSI 构成的RAID0 及USN 系统数据传输率性能比较如图7 所示。

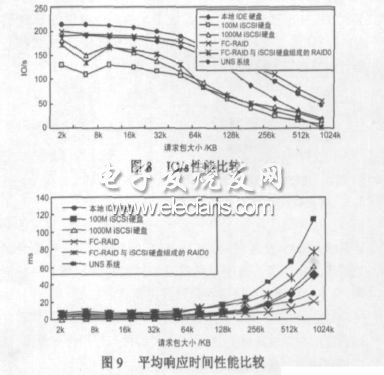

本地IDE 硬盘、100M iSCSI 硬盘、1000M iSCSI 硬盘、FC-RAID 及FC-RAID 与iSCSI 构成的RAID0 ,以及USN 的IO/ s 性能比较如图8 所示。

本地IDE 硬盘、100M iSCSI 硬盘、1000M iSCSI 硬盘、FC-RAID及FC-RAID 与iSCSI 构成的RAID0 ,以及USN 的平均响应时间性能比较如图9 所示。

本地IDE 硬盘、100M iSCSI 硬盘、1000M iSCSI 硬盘、FC-RAID 及FC-RAID 与iSCSI 构成的RAID0 ,以及USN 的CPU 占用率比较如图10 所示。

实验结果分析

请求文件或数据块大小对存储系统性能的影响从图7、图8 和图9 中单条曲线的走势可以看出,当请求文件或数据块较大时,从目的盘或系统上读写数据耗费的时间长,通过网络传输的时间也相应增加,所以:小包的平均响应时间< 大包的平均响应时间,小包的IOps > 大包的IOps。请求包大时,针对一个请求包所进行的额外操作较请求包小时少,连续的读写所耗费的时间小于小包读写所耗费的时间,因此:小包的MBps < 大包的MBps。

服务器端iSCSI 盘的各项性能表现趋势在100M以太网和千兆以太网环境中不同请求包大小的情况下符合上述规律,本地IDE 硬盘、FC-RAID 和USN 系统也符合上述述规律。

性能分析

从图7、图8 和图9 可以看出, I/O 请求在1k~128kB 时,USN系统的I/O 请求响应速度比本地IDE 硬盘、FC-RAID、100M远程iSCSI 硬盘和1000M iSCSI 硬盘快的多。 当I/O 请求大于128kB 时,USN 系统的I/O 请求响应速度比FC-RAID 的 I/ O 请求响应速度略慢,比其它存储子系统的速度快的多,最高速度可达45MB/ s。 其原因是我们在USN 的服务器端除加载了GMPFS(支持使用多种访问协议用户) 和ASA(提供服务器通道和附网高速通道) 的同时,还加载了我们实验室以前开发的智能预取、硬盘缓存技术(DCD) 、负载均衡和零拷贝系统或软件模块,所以,不论是大I/O 请求还小I/O 请求,都能提供极好的I/O 请求响应性能。 而FC-RAID 由于自身的数据校验等时延等特性,对小的I/O 请求响应速度较慢,对越大的I/O请求响应速度越快。

对于USN 的iSCSI 盘存储子系统,从实验结果可以看出,当请求数据块较小时,100M网络环境下的性能和1000M网络环境下的性能差别不明显,随着请求块或文件逐步增大,两者IOps 和MBps 的差距越来越大。请求数据块为1024K时,仅更换网络传输中的数据链路层和物理层,从100M 网络环境提升到1000M网络环境,磁盘数据传输率得到较大的提高,后者约是前者的3 倍。

从图10 可以看出,100M的iSCSI 存储子系统的CPU 占用率最高,原因是在响应用户的I/O 请求,要求服务器不断的对iSCSI 的协议数据单元进行封装和解封装。 本地的IED 硬盘CPU 占用率最低,USN 系统的服务器端CPU 占用率次之,原因是USN 系统中小的I/O 请求直接经过服务器处理,而大的I/O 请求经过附网高速通道由存储设备自身处理。

结论和展望

我们提出、设计和实现的统一存储网络系统,全部采用IP互联设备,价格比光纤通道低得多,在管理软件的开发实现上以及系统的使用维护上,都具有多得多的资源和经验。 并且,千兆以太网技术比光纤通道技术发展迅速,10Gbps 以太网交换机已经推出并在市场上热销,其性能前景也比光纤通道交换机好得多。 所有这些为统一存储网络的产品化打下了坚实的基础。

目前,我们已经从理论、结构和实践上实现了统一存储网络原型系统,现在,我们正在开发和完善多用户、多功能、多种平台支持的iSCSI 设备,设计和实现新的安全和高可用文件系统,以便为统一存储网络系统产品化后能真正为广大企业,尤其是为广大中小企业提供开放性、性能、可展性、性/ 价比都更好的海量存储系统。